메타에서 AI기술의 발전을 가속화 할 수 있도록 대규모 언어 모델(LLM)을 오픈소스로 공개했습니다.

OpenAI의 GPT로 테스트를 진행하려면 카드를 등록해서 API비용도 지불해야되고 여러 가지 껄끄러운 부분이 많은데

무료로 로컬에서 테스트해볼 수 있는 괜찮은 모델이니 관심 있으신 분들은 설치해서 테스트 해보시길 바랍니다.

우선 가장 쉽게 테스트 해보기 위해서는 Ollama라는 클라이언트 프로그램을 설치해야 합니다.

Download Ollama on Windows

Download Ollama on Windows

ollama.com

사이트에 접속해서 운영체제를 선택한 후 Ollama를 다운로드 받습니다.

(설명은 윈도우로 하겠습니다)

다운로드가 완료되면 설치파일을 실행하여 설치를 진행합니다.

설치가 완료되면 윈도우 우측 하단에 트레이 아이콘을 확인해 Ollama가 실행중인지 확인합니다.

(정상적으로 설치되면 자동 실행됩니다)

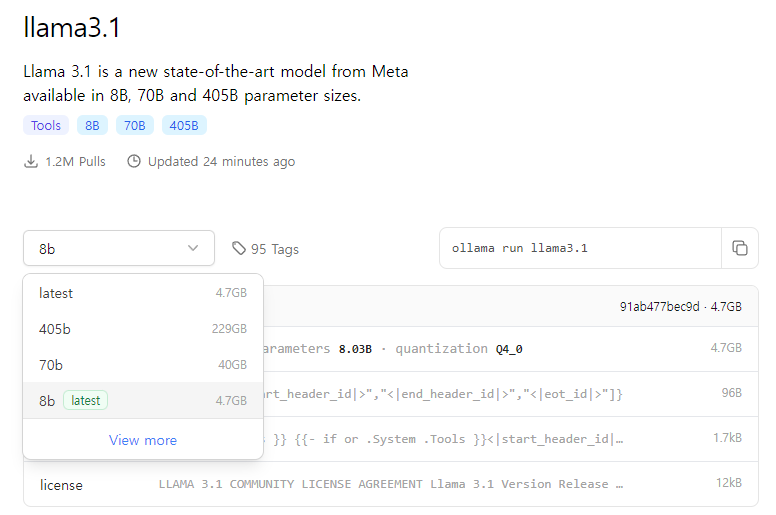

llama3.1

Llama 3.1 is a new state-of-the-art model from Meta available in 8B, 70B and 405B parameter sizes.

ollama.com

라마3.1에는 현재 405b, 70b, 8b 세가지 모델이 존재합니다.

모델 숫자의 의미는 파라미터 개수로 각 4050, 700, 80억개의 파라미터가 존재하는 것을 의미합니다.

일반적으로 파라미터 개수가 많을수록 높은 정확도를 기대할 수 있지만

용량이 크기 때문에 원하는 용도에 맞는 모델을 다운로드하시길 바랍니다.

모델을 선택하고 우측 복사 버튼을 클릭해서 모델 다운로드 명령어를 복사해줍니다.

(뒤에 모델명을 입력하지 않으면 latest인 8b모델이 다운로드 됩니다)

명령 프롬프트를 관리자 권한으로 실행하고 복사한 명령어를 입력하면 다운로드가 진행됩니다.

(중간에 실패한 경우 명령어를 다시 입력하면 이어서 진행됩니다)

다운로드가 완료되면 메세지를 입력해 라마3.1 언어 모델을 사용해볼 수 있습니다.

라마 모델은 영어를 기준으로 학습됐기 때문에

기본 버전을 사용하여 일반적인 한글 답변을 요구하면 조금 성능이 떨어지는 듯한 모습을 볼 수 있습니다.

추가로 /?를 입력해보면 사용가능한 명령어 목록을 확인할 수 있습니다.

(CMD창을 종료 시킨 후 다시 실행할 때도 ollama run llama3.1 명령어를 사용하면 됩니다)

질문 입력 창에서 나가려면 /bye

모델을 삭제하려면 ollama rm llama3.1 을 입력해주면 됩니다.

library

Get up and running with large language models.

ollama.com

ollama라고 해서 라마 모델만 돌릴 수 있는건 아니고 다른 모델들도 받아서 테스트 해볼 수 있습니다

Llama3외에 유명한 언어 모델은 구글의 Gemma2, 알리바바의 Qwen2 모델 등이 있습니다.

다 비슷한 성능이지만 Qwen2 모델이 공식적으로 한국어를 지원한다고 나와있기도 하고

한글로 질문했을 때 가장 잘 이해하는 느낌이었네요.

모델을 로컬에 다운받았기 때문에 네트워크 연결이 되지 않아도 사용이 가능하지만

모델을 돌리는 데 컴퓨터의 리소스를 엄청나게 잡아먹기 때문에

웬만한 하드웨어로는 원하는만큼의 속도가 나오지 않습니다.

따라서, 라마3 모델을 이용해서 서비스를 하려면

모델은 서버에서 돌리고 답변을 보내주는 식으로 구현해야 될 것 같아서

어쨌든 네트워크 연결은 필요해 보이네요.

다음은 답변 성능을 향상시키기 위해 LangChain을 활용해서 ollama를 구동시키는 방법에 대해 알아보겠습니다.

[Python] LangChain으로 Llama3 구동해보기 [02]

라마3는 아무래도 오픈소스이고 영어 기준으로 학습되었다보니한국어에 대해서 명확하게 처리하지 못하는 문제가 있습니다. 이런 문제를 해결하려면 한국어로 파인튜닝된 모델을 사용하거나,

dev-drive.tistory.com

'파이썬' 카테고리의 다른 글

| [Python] HuggingFace로 Llama모델 학습(파인튜닝) 시키기 [05] (3) | 2025.06.07 |

|---|---|

| [Python] HuggingFace로 오픈소스 AI모델 구동해보기 [04] (1) | 2024.09.10 |

| [Python] GPU로 AI 모델을 구동하기 위한 PyTorch + CUDA + cuDNN 설정 방법 [03] (0) | 2024.07.29 |

| [Python] LangChain으로 Llama3.1 언어 모델 구동해보기 [02] (2) | 2024.06.27 |

댓글